# 【AI绘画】Stable Diffusion实战(四-1):ControlNET插件介绍,效果展示(让小姐姐摆出你要的pose!)

作者:华王

星球:https://t.zsxq.com/0dgMjetVg (opens new window)

学习、分享、成功;提高效率,有所收获!😄

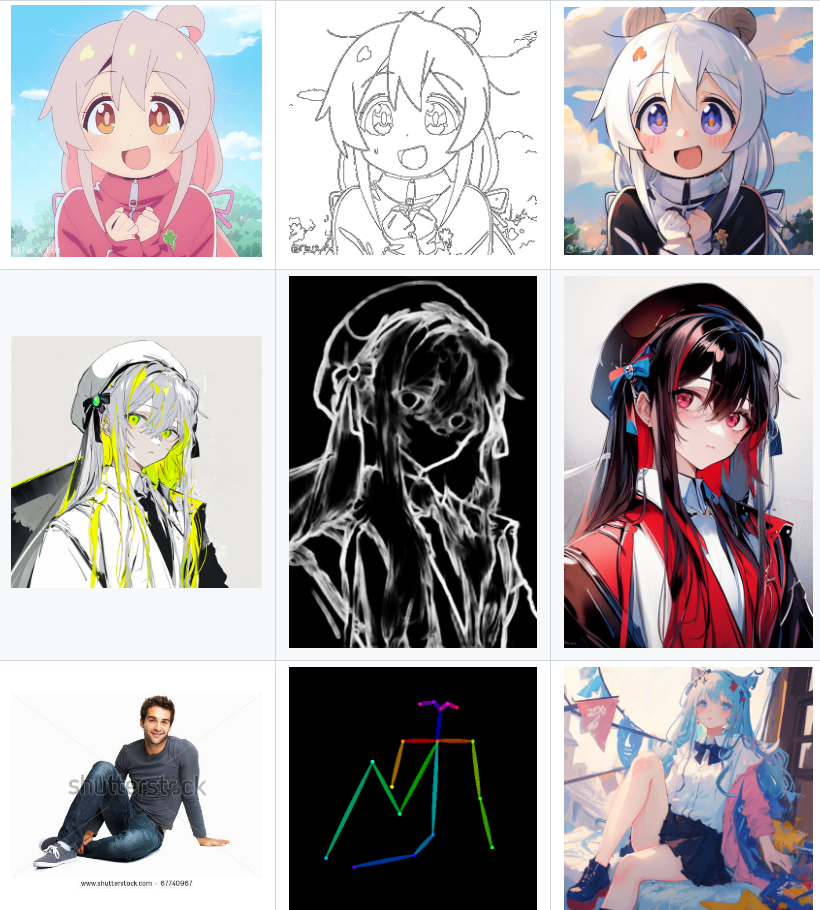

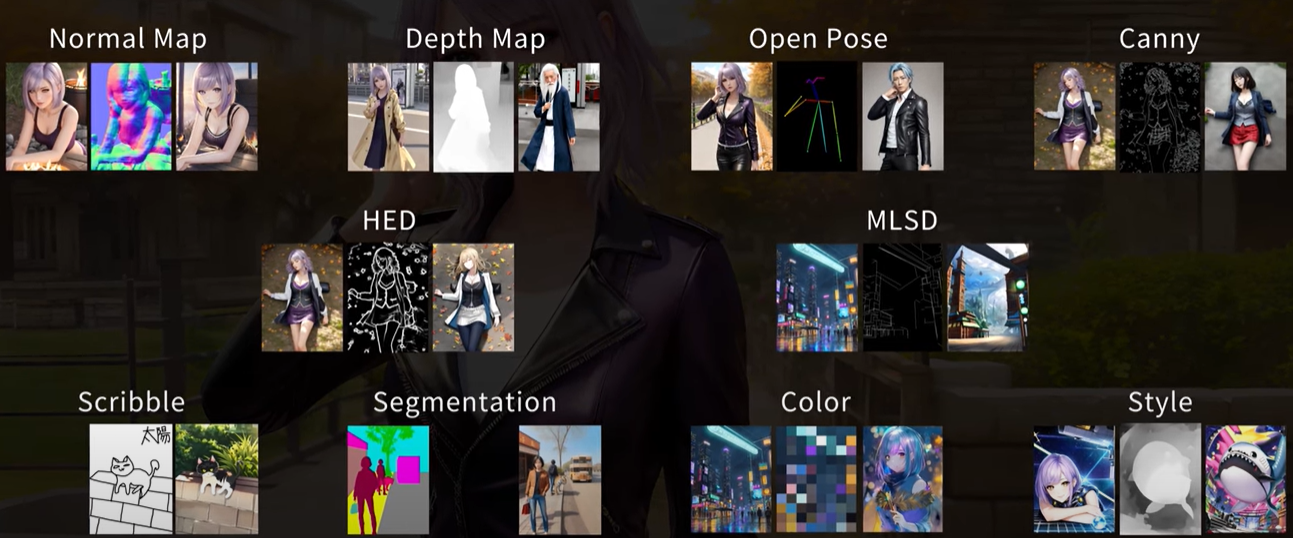

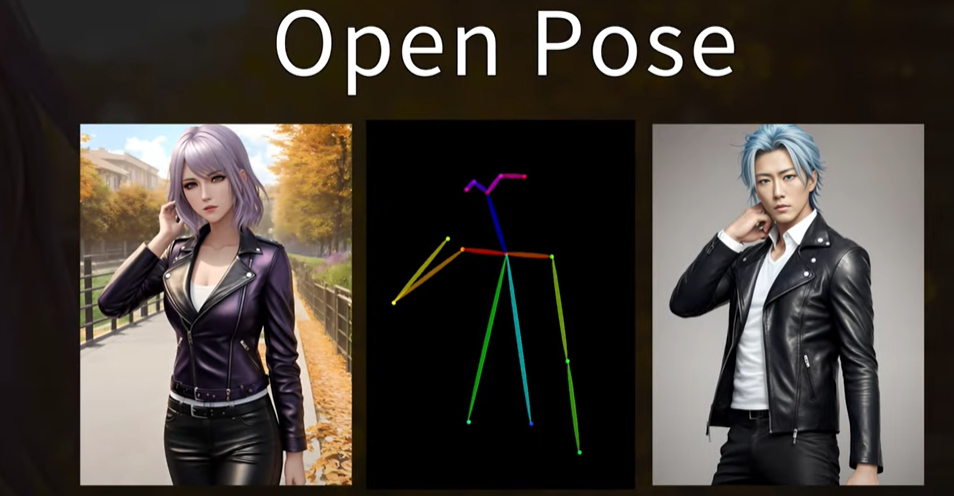

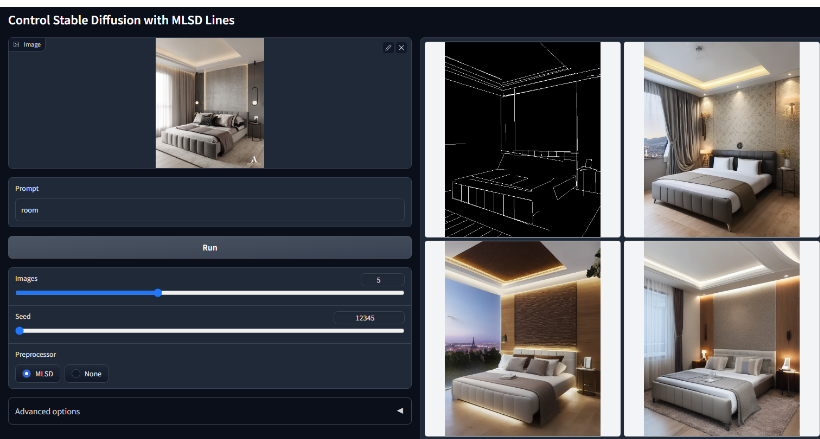

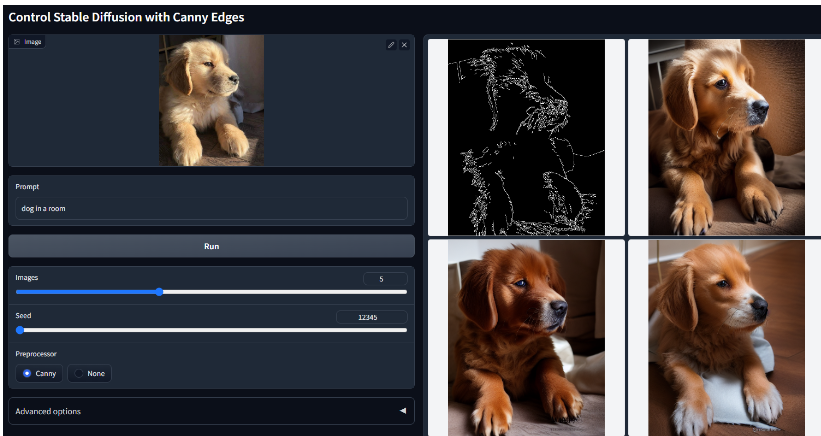

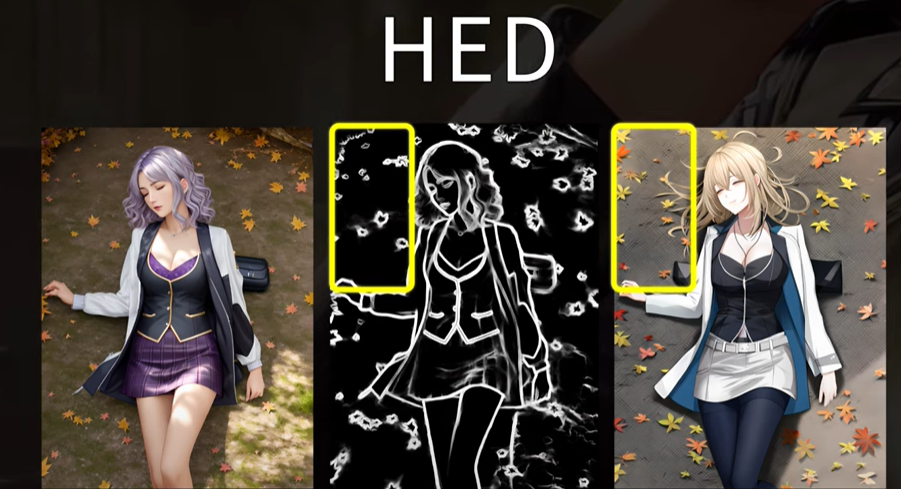

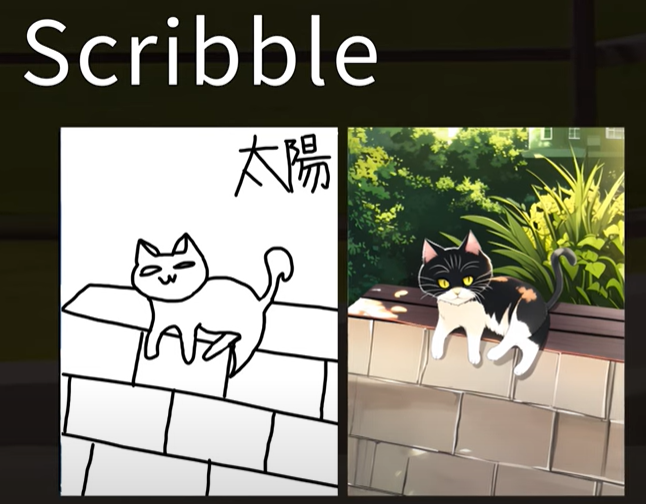

SD插件ControlNET的诞生,无法自定义姿势成为过去,自定义姿势;根据线稿、骨骼、其他图片生成全新的图,AI绘图自主可控;包括边缘检测,深度信息估算;姿态,手势检测;分割等等

场景:个人pose图,模特换装;装修出图;设计草图快速复原;颜色快速更换等等

此扩展用于AUTOMATIC1111的稳定扩散Web UI,允许Web UI将ControlNet添加到原始稳定扩散模型以生成图像

看下效果,就知道有多强了

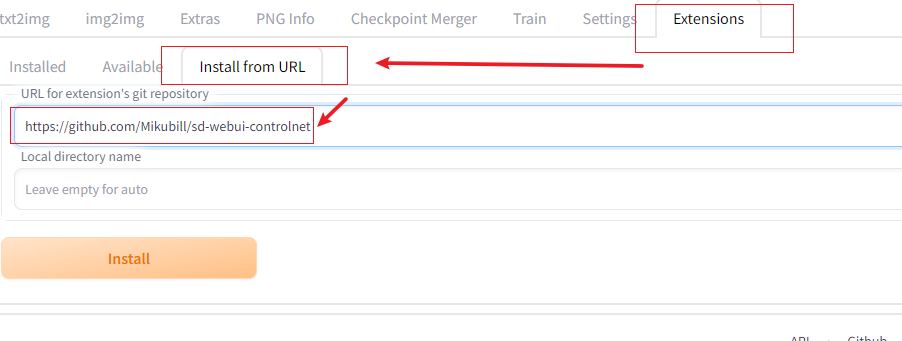

# 安装ControlNET插件:

地址:

github.com/Mikubill/sd-webui-controlnet

找到右上角的扩展,然后点击从网址安装,把网址输入到下方

报错了: AssertionError: extension access disabled because of command line flags 解决: cd xx/stable-diffusion-webui/extensions git clone https://github.com/Mikubill/sd-webui-controlnet

下载完之后需要重新启动服务才可以生效(启动服务前下载)

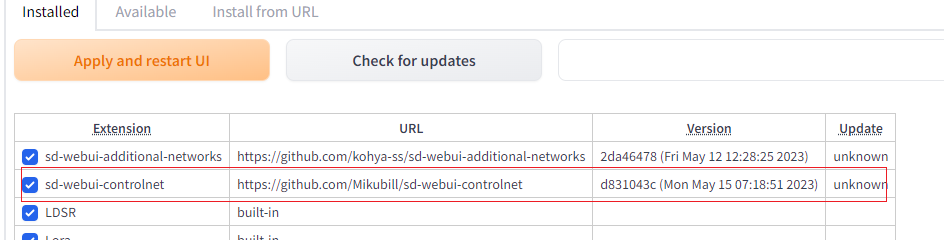

成功标志:

# 模型下载

ControlNET 相关模型(8个),不想自己下载的,公众号直接回复【BB】,领取网盘下载链接

自己下载: huggingface.co/lllyasviel/ControlNet-v1-1/tree/main

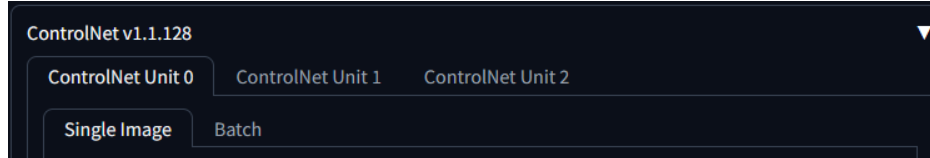

再上面一行的选中 设置(settings),找到contronet ,调试多个contronet为3,最后重新载入ui

# 插件controlnet介绍

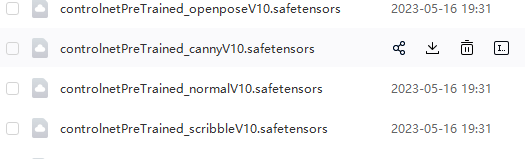

把模型放到刚下载的插件\extensions\sd-webui-controlnet\models下,直接应用并重启界面

首页下方这块有ControlNET的模块,表示成功

基础参数配置与介绍

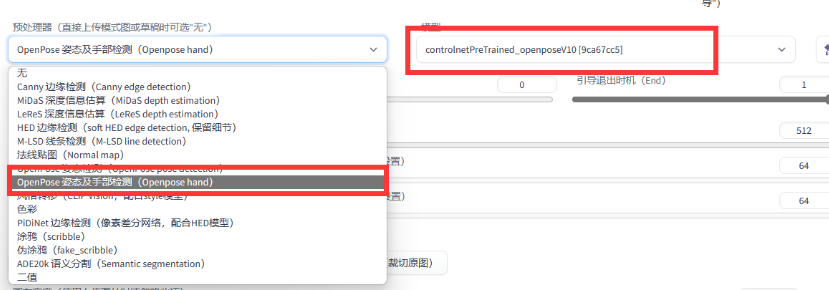

预处理器 先选OpenPose,后面的模型一定跟预处理器对应一致,比如:预处理器我们选了OpenPose,模型选OpenPose命名的

# 模型介绍

参考: github.com/lllyasviel/ControlNet-v1-1-nightly

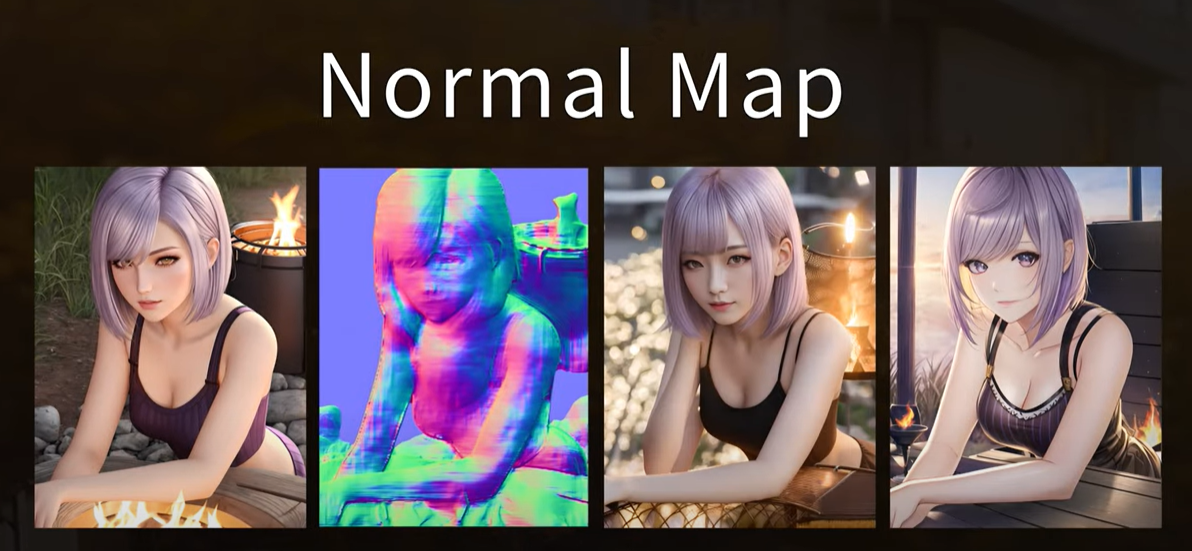

1 Normal Map 法线贴图控制稳定扩散 模型文件:control_v11p_sd15_normalbae.pth 用途:用在模拟3D模型的表面细节和凹凸纹理

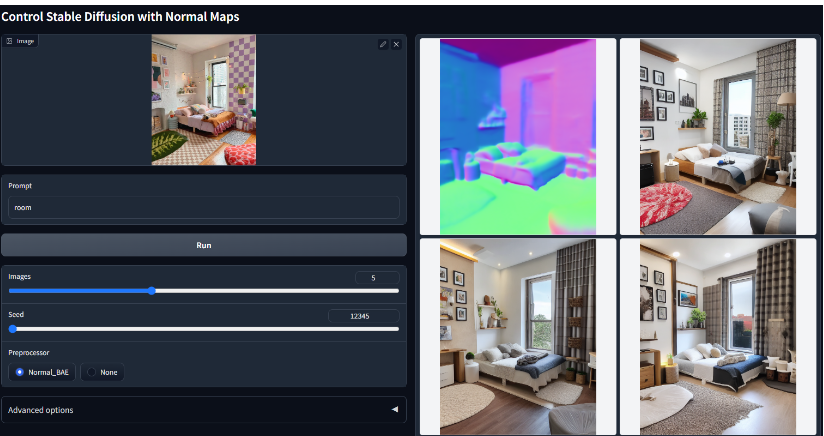

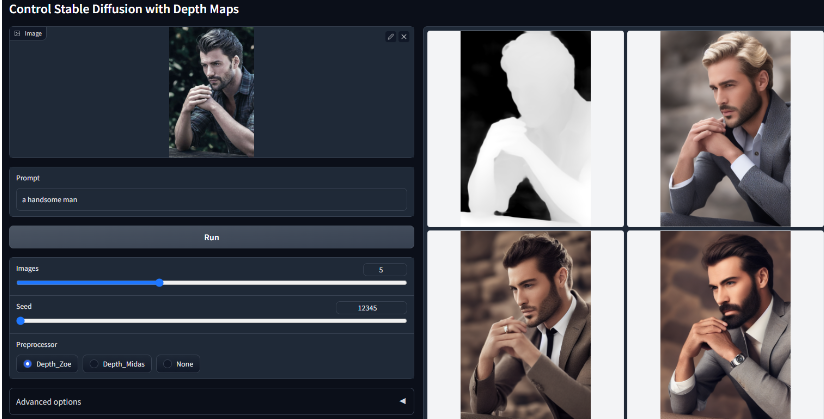

2 Depth(MiDaS和LeReS深度信息估算) 使用深度贴图控制稳定扩散。 模型文件:control_v11f1p_sd15_depth.pth; 预处理器:Depth_Midas、Depth_Leres、Depth_Zoe

3 OpenPose 使用Openpose控制稳定扩散。 模型文件:control_v11p_sd15_openpose.pth

4 MLSD 用M-LSD直线控制稳定扩散。 模型文件:control_v11p_sd15_mlsd.pth 适合建筑物和室内空间

5 Canny 用Canny映射控制稳定扩散。 模型文件:control_v11p_sd15_canny.pth

6 Hed 用软边控制稳定扩散 模型文件:control_v11p_sd15_softedge.pth 跟Canny基本相似,都是边缘检测提取线稿,唯一的不同是,Canny提取的线稿边更锐利,Hed的线稿边缘更柔结果更加接近原图

7 scribble 使用涂写控制稳定扩散 模型文件:control_v11p_sd15_scribble.pth

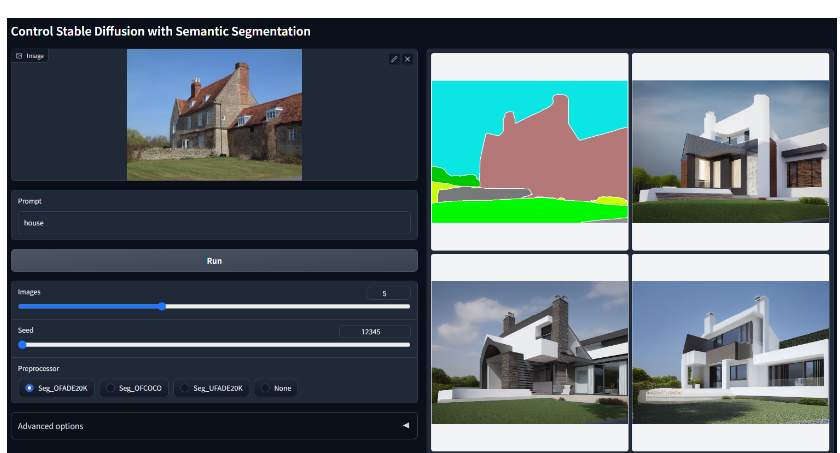

8 seg 用语义分割控制稳定扩散。 模型文件:control_v11p_sd15_seg.pth

AI革新文字后,图像也是岌岌可危,微调模型的出现,是的训练也变得简单,未来AI绘画,可期!!